کهنه کارها به خوبی می دانند چه قدر واژه ایندکس و فرآیند ایندکس شدن در دنیا امروز اهمیت دارد. اصلا به همین دلیل است که ما منابع مالی زیاد و زمان فراوانی را برای سئو on-page و off-page خود اختصاص و کارهایی مثل بهینه سازی تصاویر در وردپرس، تغییر و بهبود ساختار سایت یا بهینه سازی لینک های داخلی را انجام می دهیم. اما بعضی از وب سایت های مدرن و سطح بالایی که اتفاقا سر و صدای زیادی در وب به پا کرده اند و خیلی سرشناس هستند برخی از موارد تکنیکی و فنی را در سئو فراموش می کنند. اگر شما هم یک از صاحبان این قبیل وب سایت ها هستید و کلماتی مثل فایل فایل Robots.txt ، نقشه سایت، متاتگ های Robots و میکروفرمت های سئو برایتان غریب است احتمالا راه دشواری را از این پس در پیش خواهید داشت!

البته جای نگرانی نیست. حتی اگر فایل Robots.txt و چگونگی تنظیم آن در بهینه سازی سایت برایتان کلماتی تازه باشند با آموزش امروز به خوبی می توانید اقدام به ساخت فایل robots.txt برای وردپرس و به عنوان یکی از کلیدی ترین مفاهیم در سئو وردپرس رسیدگی کنید!

در این مطلب میخوانید:

تنظیم فایل Robots.txt در سئو در وردپرس

فایل Robots.txt چیست و چه می کند؟

Robots.txt یک فایل متنی است که حکم راهنما موتور جستجو را دارد. به این شکل که ربات های مختلف گوگل را (اسپایدر ها و خزنده ها) برای کراول کردن و سپس ایندکس کردن مطالب یاری می دهد. فایل Robots.txt به صورت ایده آل در دایرکتوری معتبر شما قرار می گیرد تا دسترسی ربات ها بدان آسان شود.

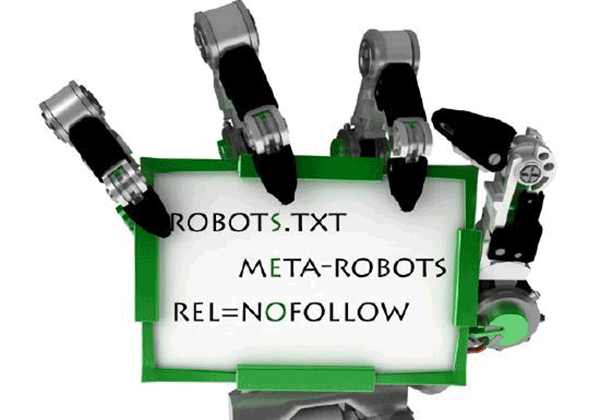

فایل Robots.txt باید استانداردهای ثابتی داشته باشد که در پروتکل REP در سال 1996 تا 2005 تنظیم شده است. در طول زمان این فایل ها تغییرات مثبت زیادی داشته اند تا بتوانند از دستورالعمل های خزنده های گوگل یا ریز داده های rel=“nofollow” پشتیبانی کنند.

اما این فایل ها دقیقا چه می کنند؟

فایل Robots.txt یک جهت یاب است. راهنمایی برای این که یک بخش از سایت ما را چه طور ایندکس کنند. به علاوه در صورتی که همه عوامل درگیر دیگر در سایت به خوبی عمل کنند داشتن این فایل سرعت ایندکس شدن مطالب را بالا می برد و نتیجه خوبی در سئو به همراه خواهد داشت. بنابراین طراحی و تنظیم این فایل ها برای هر سایت بسیار سرنوشت ساز خواهد بود. شایسته است در آزمون های سئو سایت حتما به صورت دوره ای Robots.txt به عنوان یکی از فایل های حیاتی سایت بررسی شود.

در تنظیم این فایل تصمیم می گیریم که چه بخش هایی از دید موتور جستجو پنهان بمانند و چه بخش هایی دیده شوند. تمام این موارد را با هم برای تنظیم فایل Robots.txt به صورت بهینه مرور می کنیم. ابتدا باید فایل را باز کرده و بدان دسترسی پیدا کنید.

نحوه دسترسی به فایل Robots.txt

همان طور که قبلا می دانستید دسترسی به این فایل در هر کجا که باشید و با وارد کردن آدرس زیر در نوار مرورگر امکان پذیر می باشد:

www.website-example.com/robots.txt

کافی است دامین سایت خود را در آدرس بالا جایگزین کنید. توجه داشته باشید که در دسترس بودن این فایل برای همه به این معنا است که شما نمی توانید دیتا سایتتان را مخفی کنید. بنابراین هر لحظه ممکن است ربات های مخرب یا خزنده ها با استفاده از اطلاعاتی که در فایل robots.txt درباره ناوبری یا نقشه سایت شما وجود دارد سواستفاده کنند.

چه بخش هایی را با Robots.txt مخفی می کنیم؟

دسته بندی ها، دایرکتوری ها و صفحات مختلف سایت را می توان با این فایل مخفی کرد. بدین منظور در این فایل از دستور معروف disallow استفاده می شود که صفحات را از دید موتور جستجو مخفی می کند.

برخی از صفحاتی که باید با استفاده از دستور disallow و قرار دادن آن در فایل Robots.txt مخفی شوند عبارتند از:

- صفحاتی با محتوا تکراری

- صفحه جستجو که کاربر در آن محصولی را سرچ می کند

- صفحات مربوط به اکانت و حساب های کاربری کاربران

- صفحه ادمین یا لاگین سایت

- صفحه بازخورد مشتریان

- صفحه چت های کاربران

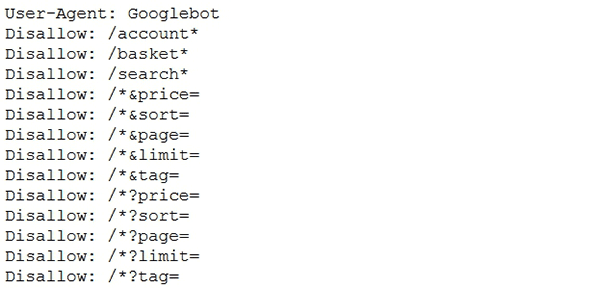

این صفحات بعد از استفاده از دستور disallow در فایل به شکل زیر خواهند بود: نمونه فایل rebots.txt

نحوه استفاده از فایل Robots.txt

فایل های Robots.txt بسیار منعطف هستند و می توان از آن ها در جهت اهداف مختلف استفاده کرد. مهم ترین کاربرد آن ها برای هر وبمستری امکان دسترسی به صفحات و allow یا disallow تعداد زیادی از آن ها در آن واحد بدون نیاز به دست کاری حتی یک کد در هر پیج می باشد.

به عنوان مثال شما می توانید دسترسی همه خزنده های گوگل برای دیدن صفحه زیر بلاک کنید:

User-agent: * Disallow: /

یا این که دسته بندی خاصی در سایت را به شکل زیر برای ربات های گوگل مسدود کنید:

User-agent: * Disallow: /no-index/

مهم تر از همه فایل به شما این اجازه را می دهد تا صفحات خاص، دسته های خاص و حتی کدهای CSS را برای دیده شدن توسط ربات ها اولویت بندی کنید:

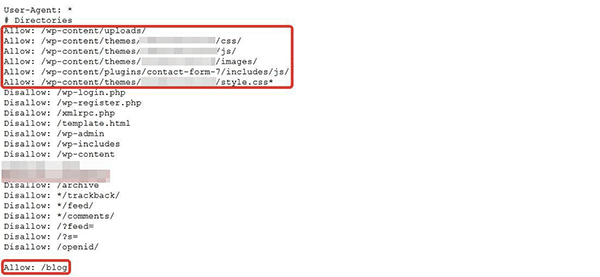

در این روش قرار دادن ترتیب این بخش ها به گوگل می گوید که اول کدام بخش های سایت ایندکس شوند و مثلا همان طور که در تصویر بالا مشخص است بلاگ در آخر دیده شود. در تصویر بالا مشاهده می کنید که تنها دسته بندی و صفحات وردپرس disallow شدند و باقی بخش های نظیر پلاگین های JS و استایل های CSS برای ربات ها allow شده اند.

کاربران مبتدی شدیدا دقت کنند!

کاربران تازه کاری که به تازگی وب سایتشان را راه اندازی کرده اند باید خیلی بیش تر در تنظیم این فایل دقت داشته باشند. کمی بی دقتی و حواس پرتی شما کافی است تا به جای یک دسته بندی خاص کل سایت disallow شود و به طور کلی از صفحه روزگار محو گردد!